Les 4 modes d’utilisation d’une IA gÃĐnÃĐrative à connaÃŪtre pour ÃĐviter le ÂŦ botshit Âŧ

25 juin 2024

Comment utiliser l’IA gÃĐnÃĐrative de la meilleure des façons… en attÃĐnuant ses risques ÂŦ d’hallucinations Âŧ ? Des chercheurs apportent une rÃĐponse à travers un modÃĻle qui croise la capacitÃĐ Ã vÃĐrifier les informations gÃĐnÃĐrÃĐes par l’IA à l’importance de l’enjeu de ces informations. Utile à l’heure de l’expansion rapide de ChatGPT et consorts.

ÂŦ Botshit Âŧ. L’expression n’est pas des plus heureuses mais elle a le mÃĐrite d’Être parlante. ÃvoquÃĐe dans cet article du Guardian par le professeur à la Bayes Business School de Londres, AndrÃĐ Spicer, elle correspond sommairement à la facultÃĐ de dire n’importe quoi non pas des humains (ÂŦ bullshit Âŧ) mais des machines ! Un phÃĐnomÃĻne ÃĐvidemment liÃĐ Ã l’ÃĐmergence spectaculaire au cours de la derniÃĻre annÃĐe de l’intelligence artificielle (IA) gÃĐnÃĐrative.

Rappelons en effet que ces modÃĻles sont probabilistes. Une IA gÃĐnÃĐrative rÃĐpond aux questions qu’on lui pose en faisant des suppositions basÃĐes par des statistiques. Elle ne cherche pas le vrai ou le faux (elle n’est pas en capacitÃĐ de le savoir) mais le plus probable. Souvent, ses rÃĐponses sont correctes. Mais parfois, ce n’est pas le cas – malgrÃĐ leur cohÃĐrence apparente. C’est ce qu’on appelle des ÂŦ hallucinations Âŧ.

Lorsque les humains utilisent ce contenu mensonger pour des tÃĒches, cela devient ce que nous appelons de la ÂŦ botshit Âŧ Âŧ, indique AndrÃĐ Spicer.

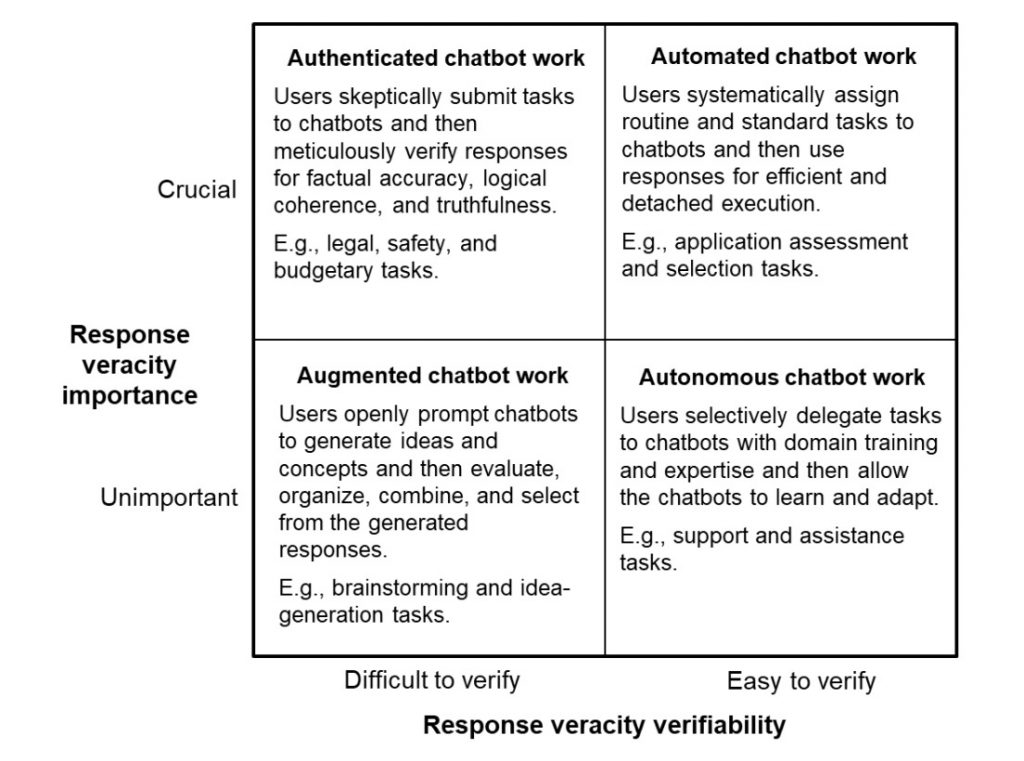

Partant de ce constat, le chercheur propose avec deux de ses collÃĻgues, dans un article acadÃĐmique paru il y a quelques mois, d’identifier les cas d’usage de l’intelligence artificielle gÃĐnÃĐrative afin d’attÃĐnuer ces risques. Il en dÃĐcoule un modÃĻle en deux dimensions :

- La capacitÃĐ Ã vÃĐrifier la vÃĐracitÃĐ des rÃĐponses

- Et l’importance de la vÃĐracitÃĐ des rÃĐponses

En consÃĐquence, il existe quatre situations diffÃĐrentes de collaboration entre les humains et les IA gÃĐnÃĐratives.

1- Mode ÂŦ autonome Âŧ – tÃĒche facilement vÃĐrifiable et à faible enjeu

Dans ce premier mode, l’utilisateur peut dÃĐlÃĐguer des tÃĒches spÃĐcifiques à la machine en les vÃĐrifiant rapidement, ce qui est susceptible d’augmenter la productivitÃĐ et d’ÃĐliminer les tÃĒches routiniÃĻres. Les auteurs citent par exemple des demandes courantes de clients ou le traitement de demandes administratives courantes.

2- Mode ÂŦ augmentÃĐ Âŧ – tÃĒche difficilement vÃĐrifiable et à faible enjeu

Dans ce cas, l’utilisateur devrait utiliser la rÃĐponse gÃĐnÃĐrÃĐe par l’IA de maniÃĻre augmentÃĐe, c’est-à -dire qu’il devrait les utiliser pour ÂŦ augmenter Âŧ ses capacitÃĐs humaines. On pense ÃĐvidemment ici aux exercices crÃĐatifs de remue-mÃĐninges et de gÃĐnÃĐration de nouvelles idÃĐes. Les rÃĐponses ne sont pas pleinement exploitables en l’ÃĐtat mais, triÃĐes, modifiÃĐes et retravaillÃĐes, elles peuvent aider à gagner en productivitÃĐ et en crÃĐativitÃĐ.

3- Mode ÂŦ automate Âŧ – tÃĒche facilement vÃĐrifiable et à grand enjeu

Comme la vÃĐracitÃĐ de l’information est cruciale ici, les utilisateurs doivent vÃĐrifier les rÃĐponses de l’IA. Ces derniers lui attribuent alors des tÃĒches simples, routiniÃĻres et relativement standardisÃĐes. Les auteurs parlent d’une forme de contrÃīle de qualitÃĐ et citent l’exemple de l’analyse et la prÃĐ-approbation des demandes de prÊt dans une banque.

De grandes quantitÃĐs d’informations pourraient Être utilisÃĐes pour vÃĐrifier les dÃĐclarations faites. Cependant, la dÃĐcision sera probablement relativement cruciale et à enjeux ÃĐlevÃĐs. Cela signifie que mÊme si le chatbot peut produire automatiquement une dÃĐclaration vÃĐridique, celle-ci doit encore Être vÃĐrifiÃĐe et approuvÃĐe par un banquier formÃĐ Âŧ, indiquent-ils.

4- Mode ÂŦ authentifiÃĐ Âŧ – tÃĒche difficilement vÃĐrifiable et à grand enjeu

Dans ce dernier cas – celui qui pose le plus de problÃĻmes, les utilisateurs doivent ÃĐtablir des garde-fou et garder leur pensÃĐe critique et leur capacitÃĐ de raisonnement pour estimer la vÃĐracitÃĐ des rÃĐponses de l’IA.

Dans ces contextes, les utilisateurs doivent structurer leur engagement envers la rÃĐponse du chatbot et adapter les rÃĐponses au fur et à mesure que les (in)certitudes se dÃĐvoilent Âŧ, expliquent les auteurs.

Exemple ? Une dÃĐcision d’investissement dans une nouvelle industrie avec peu d’informations prÃĐcises – difficile donc de vÃĐrifier les rÃĐponses d’une IA en la matiÃĻre. Les robots peuvent mettre en lumiÃĻre des dÃĐtails ou des problÃĻmes nÃĐgligÃĐs, ajoutant de la profondeur et de la rigueur aux dÃĐcisions critiques, surtout dans des situations incertaines ou ambiguÃŦs.

Un modÃĻle trÃĻs facile à appliquer dans ses interactions avec l’IA !

DÃĐcouvrez nos formations :