Shadow IA : quand les ĂŠquipes introduisent en cachette l’IA dans leur organisation

16 juillet 2025

Qu’on l’appelle ÂŤÂ IA clandestine , ÂŤÂ intelligence artificielle de l’ombre  ou ÂŤÂ Shadow IA , l’utilisation de l’IA dans le cadre de son travail avec ses outils personnels reprĂŠsente une rĂŠalitĂŠ pour beaucoup d’organisations. Et une menace majeure. DĂŠcryptage.

L’informatique parallèle ou fantĂ´me (ÂŤÂ shadow IT ) est un phĂŠnomène bien connu des directions informatiques. Mais depuis l’ĂŠmergence de ChatGPT et des autres outils d’IA gĂŠnĂŠrative, il prend une nouvelle ampleur avec des salariĂŠs qui se servent de ces robots conversationnels pour ĂŠcrire des courriels, rĂŠaliser des prĂŠsentations, produire des textes, approfondir leur stratĂŠgie… souvent sans en parler Ă leur hiĂŠrarchie.

Cette dernière n’est toutefois pas dupe : selon une ĂŠtude Dataiku & Harris Poll, 94 % des dirigeants suspectent leurs collaborateurs d’utiliser des outils d’IA gĂŠnĂŠrative sans autorisation ! Un chiffre peut-ĂŞtre un peu exagĂŠrĂŠ mais qui traduit tout de mĂŞme l’ampleur potentiel du sujet, alors que plus d’un cadre sur trois dit utiliser des outils d’intelligence artificielle (IA) gĂŠnĂŠrative dans le cadre professionnel au moins une fois par semaine, selon une enquĂŞte de l’Association pour l’emploi des cadres, en France.

L’IA clandestine se dĂŠveloppe gĂŠnĂŠralement dans les contextes de vide rĂŠglementaire ou d’interdiction, voire de nĂŠgligence dĂť Ă une mĂŠconnaissance de cette nouvelle technologie. Avec un risque certain de faille de sĂŠcuritĂŠ, de conformitĂŠ rĂŠglementaire ou encore de gouvernance des donnĂŠes.

Une mĂŠsaventure arrivĂŠe, entre autres, Ă Samsung. DĂŠbut 2023, le gĂŠant sud-corĂŠen de l’informatique s’est rendu compte que des ingĂŠnieurs avaient partagĂŠ accidentellement des donnĂŠes sensibles de l’entreprise (code source, notes de rĂŠunions)… en les collant dans ChatGPT pour vĂŠrifier qu’il n’y avait pas d’erreurs dedans ! Rappelons en effet que ces robots conversationnels amĂŠliorent leurs rĂŠponses futures en se nourrissant des donnĂŠes qu’ils reçoivent.

Que faire alors pour les organisations ?

En juin 2025, une enquĂŞte menĂŠe par l’Institut national de recherche en informatique et en automatique (Inria)Â et datacraft, un groupe de data scientists, s’est penchĂŠe sur ce comportement qui reprĂŠsente aussi bien des opportunitĂŠs stratĂŠgiques qu’un enjeu de sĂŠcurisation des pratiques.

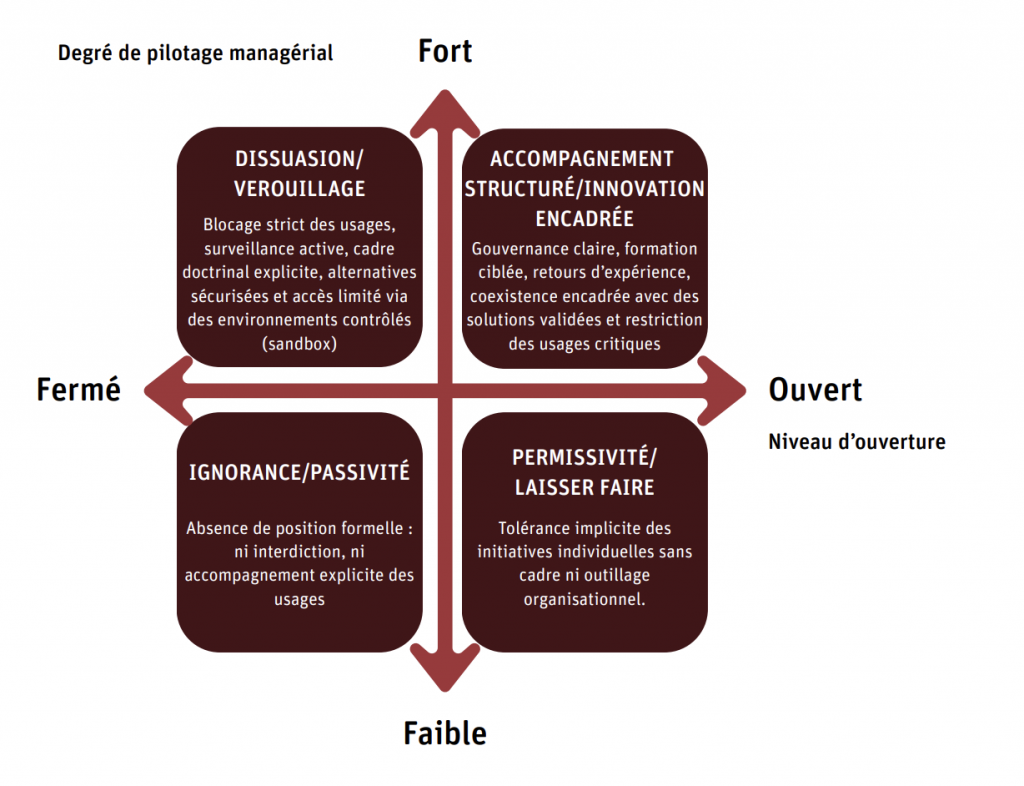

On y apprend que les organisations peuvent opter pour quatre diffĂŠrentes options :

- la dissuasion pure et simple

- l’ignorance et la passivitĂŠ

- la permissivitĂŠ

- l’accompagnement structurĂŠ et l’innovation encadrĂŠe

Les organisations pionnières, plutĂ´t que freiner les usages informels, en font un levier de transformation. Si toutes les organisations pionnières ont connu les diffĂŠrents ĂŠtats, câest la rapiditĂŠ avec laquelle elles ont transitĂŠ dâun ĂŠtat Ă lâautre qui les distingue , dĂŠcrit ainsi le rapport.

Un mouvement qui doit se faire en trois temps :

- Le pilotage – en rendant les usages visibles, en ĂŠvaluant les risques et en posant un cadre minimal

- Le partage – en ÂŤÂ socialisant  les pratiques afin d’en extraire de la valeur collective (ateliers, prĂŠsentations, dĂŠbats…)

- L’outillage – en dĂŠployant des environnements sĂŠcurisĂŠs, des guides d’usage, des chartes dynamiques et des formations adaptĂŠes.

L’objectif : reconnaĂŽtre et mettre en rĂŠseau des savoir-faire qui sont par nature diffus. Et de passer de la logique de bricolage Ă une stratĂŠgie assumĂŠe et sĂŠcurisĂŠe.

La rĂŠponse aux usages informels ne peut ĂŞtre ni lâinterdiction par dĂŠfaut, ni lâouverture sans limite. Elle passe par la mise en place dâun cadre de confiance, suffisamment clair pour sĂŠcuriser, suffisamment souple pour ĂŠvoluer , prĂŠcise le rapport.

Qui recommande ainsi de :

- DĂŠfinir les donnĂŠes et usages permis ou proscrits,

- Dâexpliciter les responsabilitĂŠs des collaborateurs comme des gestionnaires,

- De prĂŠvoir des mĂŠcanismes de supervision lĂŠgers mais rĂŠactifs,

- Dâadopter une gouvernance itĂŠrative, connectĂŠe aux pratiques rĂŠelles.

Un guide de bonnes pratiques nĂŠcessaires Ă l’heure oĂš bien des entreprises se prĂŠcipitent dans l’intĂŠgration de l’IA dans leur quotidien. Comme le pointait, dans un langage direct, Patrick Opet, le directeur de la sĂŠcuritĂŠ de la banque amĂŠricaine JP Morgan Chase :

Nous voyons des organisations dĂŠployer des systèmes qu’elles ne comprennent fondamentalement pas. Les fournisseurs de solutions doivent donner la prioritĂŠ Ă la sĂŠcuritĂŠ sur la course aux nouvelles fonctionnalitĂŠs .

IA sans conscience n’est que ruine de l’âme.